Google «заблокировал» закрытые в robots.txt страницы

обновлено: 03 августа 2020

По информации издания Search Engine Roundtable, на страницах групп Google в разделе «Рекомендации для веб-мастеров» стали появляться жалобы пользователей, указывающие на то, что алгоритмом поисковика были заблокированы ссылки некоторых страниц.

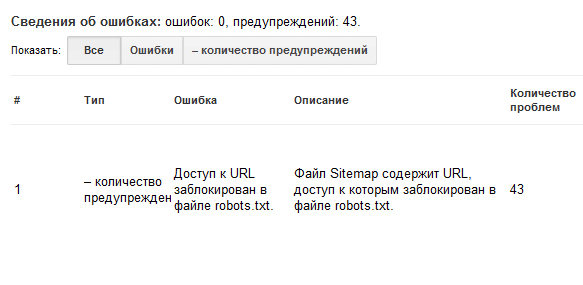

Изначально информация была воспринята большинством специалистов со смятением, но через некоторое время выяснилось, что отчеты содержали данные о ранее заблокированных в robots.txt страницах. Впоследствии они были удалены вебмастерами, но в списке эти страницы все еще помечены как «заблокированные алгоритмом».

Представитель компании Google Джон Мюллер объяснил подобный казус тем, что поисковый робот воспринял ситуацию так, как будто страницы «выпали» из индекса, а впоследствии были проиндексированы повторно. Было заявлено, что избежать подобных уведомлений в ближайшее время не получится, так как это техническая особенность алгоритма, но, к счастью, это не повлияет на ранжирование сайта в целом.